如何配置Hadoop环境

1)下载并解压hadoop-0.20.203.0.修给解压文件夹名字为hadoop-0.20.203

2)按上述所示将hadoop-0.20.203/bin路径加到PATH环境变量中

sudo gedit/etc/profile

3)修改配置文件,配置文件都在hadoop-0.20.203/conf目录下。

a.进到/hadoop-0.20.203/conf/hadoop-env.sh中,解注释JAVA_HOME

修改为:JAVA_HOME=/home/hadoop/jdk1.6

b.修改core-site.xml文件配置如下:

fs.default.name

hdfs://namenode:9000

hadoop.tmp.dir

/home/hadoop/tmp

c、修改hdfs-site.xml文件如下:

dfs.replication

2

d、修改mapred-site.xml文件如下:

mapred.job.tracker

namenode:9001

e、在masters和slave文件中分别配置主节点和各个数据节点:

masters:中写入namenode

slaves: 写入datanode1

datanode2

hadoop安装问题!!!

现在hadoop1.0都出了

简单说一下吧

你的java jdk的环境变量没有设置吧?

最好按以下步骤再做一遍:

1 用root用户安装jdk1.6以上

2 用root用户 创建hadoop用户

3 在hadoop用户下安装hadoop(你上面说的1到4)

4 修改/home/hadoop/.bash_profile将JDK和hadoop的环境变量设置好

5 安装ssh(伪集群也需要ssh)

hadoop配置

不是你的环境变量的问题。不知道楼主有没有看Hadoop官网上的介绍。Hadoop所使用的jdk需要修改 conf/hadoop-env.sh 文件,在其中设置 JAVA_HOME 环境变量: export JAVA_HOME="C:\Program Files\Java\jdk1.5.0_01” (因为路径中 Program Files 中间有空格,一定要用双引号将路径引起来) 这里必须是修改Hadoop的conf/hadoop-env.sh 文件,和机器的环境变量没有关系。

有中文文档的。在Hadoop目录的hadoop-0.20.2\\index.html

很高兴回答楼主的问题 如有错误请见谅

Hadoop 在安装时需要配置环境变量吗?

需要配置环境变量,是必须的,如果不配置的话,怎么运行hadoop 呀。

/view/78b2126e1eb91a37f1115cf7.html ,你可以参考一下这个文档

如何在windows下安装hadoop

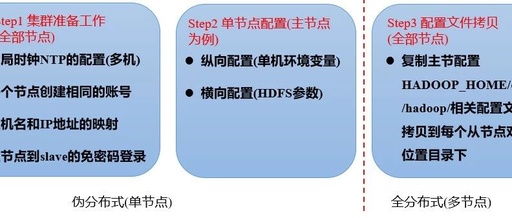

Hadoop三种安装模式:单机模式,伪分布式,真正分布式

一 单机模式standalone

单机模式是Hadoop的默认模式。当首次解压Hadoop的源码包时,Hadoop无法了解硬件安装环境,便保守地选择了最小配置。在这种默认模式下所有3个XML文件均为空。当配置文件为空时,Hadoop会完全运行在本地。因为不需要与其他节点交互,单机模式就不使用HDFS,也不加载任何Hadoop的守护进程。该模式主要用于开发调试MapReduce程序的应用逻辑。

二 伪分布模式安装

tar xzvf hadoop-0.20.2.tar.gz

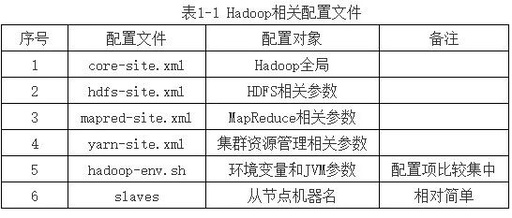

Hadoop的配置文件:

conf/hadoop-env.sh 配置JAVA_HOME

core-site.xml 配置HDFS节点名称和地址

hdfs-site.xml 配置HDFS存储目录,复制数量

mapred-site.xml 配置mapreduce的jobtracker地址

配置ssh,生成密匙,使到ssh可以免密码连接

(RSA算法,基于因数不对称加密:公钥加密私钥才能解密,私钥加密公钥才能解密)

cd /root

ssh -keygen -t rsa

cd .ssh

cp id_rsa.pub authorized_keys覆盖公钥,就能免密码连接

启动Hadoop bin/start-all.sh

停止Hadoop bin/-all.sh

三 完全分布式模式

1. 配置etc/hosts文件,使主机名解析为IP 或者使用DNS服务解析主机名

2. 建立hadoop运行用户: useradd grid>passwd grid

3. 配置ssh密码连入: 每个节点用grid登录,进入主工作目录,ssh -keygen -t rsa生产公钥,然后将每个节点的公钥复制到同一个文件中,再将这个包含所有节点公钥的文件复制到每个节点authorized_keys目录,这个每个节点之间彼此可以免密码连接

4. 下载并解压hadoop安装包

5. 配置namenode,修改site文件

6. 配置hadoop-env.sh

7. 配置masters和slaves文件

8. 向各个节点复制hadoop

9. 格式化namenode

10.启动hadoop

11.用jps检验各后台进程是否成功启动。